Auf einen Blick

Toggle>_LLMs scaling is over - start the work

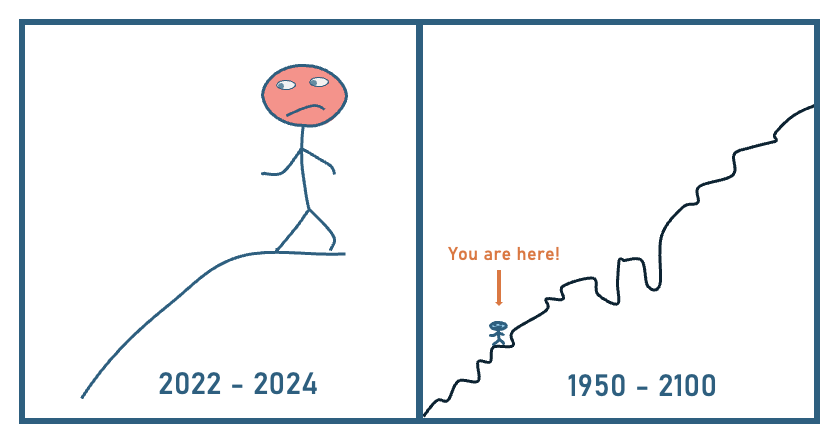

Nicht verzagen! Es geht bergauf!

In einem Post auf LinkedIn wurde die Präsentation von Ilya Sutskever beschrieben. Dieser hatte bestätigt, dass durch das fehlende, gleichartige Wachstum von guten Trainingsdaten die Skalierungsphase von LLMs eine natürliche Grenze erreicht hat.

Dr. Christian Krug hat das mit der korrekten Einordnung, dass es weitaus mehr Anwendungsgebiete mit noch nicht verwerteten Daten gibt, kommentiert.

Meine Gedanken dazu sind:

✅ Schätzungen gehen davon aus, dass 2024 ca. 180 Zettabytes an Daten produziert werden (hängt von den Quellen ab) (Kurz zur Einordnung: giga, tera, peta, exa, dann zetta bytes – 1 mit 21 Nullen)

✅ Weniger als 1% davon sind direkt von Güte, Qualität, nicht redundant, nutzbar und somit direkt für das Training von LLMs nutzbar

✅ Ohne das ich sagen will, dass das leicht war und nicht mehr oder minder die Geschichte verändert hat: Tech-Unternehmen haben sich mit Chatbot, Image- und Video- Generation diejenigen Use-Cases gezogen, die ohne Individualisierung an lokale Datenstrukturen und Arbeitsweisen auskommen und somit eine Art Greenfield-GenAI Ansatz sind

✅ Jetzt beginnt die Arbeit: Wie können wir damit Unternehmen helfen und die Mehrwerte heben?

✅ Jetzt in Datenkompetenz, gute Ausbildung, Schulungen und Compliance investieren, sodass man nicht ins Hintertreffen gerät.

Manchmal fühlt man sich wie auf dem Bild – aber man vergisst den gesamten Hub über Jahrzehnte – der ist enorm!

Jetzt beginnt die eigentliche Arbeit: Strategien, Schulungen, Datenkompetenz, individuelle Lösungen. Wenn Sie darüber sprechen möchten, wie daraus in Ihrem Unternehmen greifbarer Nutzen entstehen kann – lassen Sie uns ins Gespräch kommen.